2.3.3 線形モデル

2.3.3.2 線形回帰(通常最小二乗法)

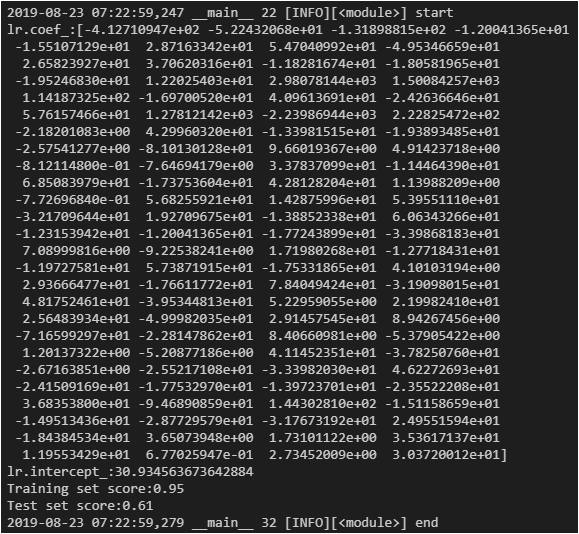

結果

ボストンの住宅価格データセットにも適用

切片は1つだけだが、傾きは特徴量104と同じだけ生成される

2.3.3.3 リッジ回帰

同じ線形回帰であるが過剰適合を防ぐためL2正規化をかけてある。

データセットは同じくボストンの住宅価格データセット

結果

ここからalpha(正則化強度 大きくするとより強い制約がかかる)を調整する。

ここからalpha(正則化強度 大きくするとより強い制約がかかる)を調整する。

デフォルトは1.0、alpha=10にする

結果、よくなっていない

alpha=0.1で試みてみる

結果、訓練・テストとも良くなっている

2.3.3.4 Lasso(ラサ)

リッジ回帰と異なりL1正則に制約を掛ける

結果、ほとんどの係数が0になっている。スコアもよくない。

alphaを0.01に変更

結果、良くなっている。使っている係数も33に増えた

ではもっとalphaを小さくすればOK?

結果、やりすぎはよくない